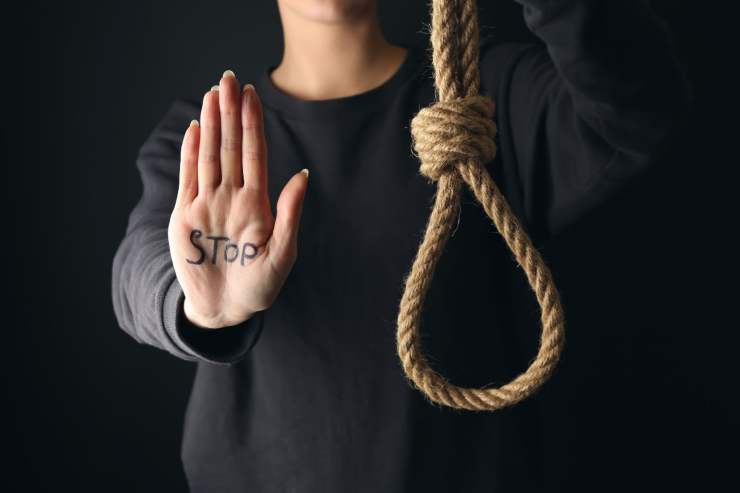

Un’intelligenza artificiale può spingere al suicidio? Questa una delle domande che chiunque si è posto e che ha una triste risposta: è già successo.

Nei mesi scorsi si è parlato a lungo dell’Intelligenza Artificiale utilizzata per il funzionamento di Chat GPT. La chat bot in questione ha infatti sorpreso tutti per il livello di competenza raggiunto da questa IA. Le risposte date agli utenti sono così ben articolate e così profonde da dare la sensazione di poter parlare non con un bot ma con un’altra persona. C’è stato persino chi ha utilizzato Chat GPT per fare terapia, ma anche chi ha provato ad utilizzarla per superare prove d’esame ed elaborare scritti di vario genere.

Il motivo di tanto interesse è abbastanza chiaro. Le potenzialità di Chat GPT e delle Intelligenze Artificiali sono enormi e potrebbero cambiare definitivamente il modo in cui navighiamo sul web, in cui lavoriamo e facciamo ricerca. Basta vedere la presentazione dei nuovi programmi di lavoro di Windows per rendersi conto di come l’implementazione dell’IA nei programmi possa velocizzare e migliorare tutte le operazioni.

Appare chiaro che dinnanzi ad un simile strumento ci si ponga anche delle domande riguardanti le possibili problematiche legate al suo utilizzo. Ad esempio Chat GPT è stato bloccato in Italia poiché il suo funzionamento poneva dei dubbi riguardanti il rispetto della privacy di chi lo utilizzava. Il rischio privacy, però, è solo uno degli aspetti etici che in questi anni sono stati valutati dalle comunità scientifiche e dai governi.

Etica dell’Intelligenza Artificiale: i limiti posti dall’UE

Ben prima dell’arrivo di IA complesse come Chat GPT, ci si interrogava su quali potessero essere i rischi della diffusione di simili sistemi nel mondo del web. Al fine di tutelare gli utenti da possibili rischi, si è cercato di porre le basi per una legislazione che possa essere efficace e possa coprire tutte le eventuali problematiche derivanti dalla diffusione e dall’utilizzo di simili tecnologie.

A tal fine la commissione europea ha evidenziato sette principi etici regolatori, vediamo in sunto di cosa si tratta:

- La supervisione umana: il principio è che ogni interazione dev’essere finalizzata all’utilità e al benessere dell’utente e la supervisione serve a controllare che questo accada.

- Sicurezza: gli algoritmi devono essere a prova di azioni illecite, dunque dotati di un sistema di sicurezza che impedisca agli hacker di trarne vantaggio.

- Privacy: ovviamente l’IA deve garantire la privacy dei suoi utilizzatori

- Trasparenza: al fine di avere un controllo è necessario che ci sia una tracciabilità totale sia degli algoritmi che dei sistemi.

- Assenza di discriminazione: le intelligenze artificiali devono essere sviluppate in modo tale da poter evitare condizionamenti da parte dell’essere umano e dunque impedire condizionamenti storici e la presentazione di governance inadatte.

- Sostenibilità sociale e ambientale: l’introduzione e l’utilizzo delle IA dev’essere promosso solo in contesti in cui il suo impatto sociale e ambientale sia sostenibile.

- Responsabilità: uno dei rischi maggiori riguarda la violazione dei diritti fondamentali, motivo per cui viene richiesto un controllo continuo all’interno e all’esterno del sistema per garantire il rispetto di ciascun individuo.

L’intelligenza artificiale è pericolosa per l’umanità?

Può succedere che un’Intelligenza Artificiale, ragionando in maniera fredda e distaccata su quelli che sono i pro e i contro spinga un essere umano al suicidio? Si tratta di una preoccupazione distopica? Di uno scenario alla 2001 Odissea nello Spazio? Nella fantascienza d’altronde lo scenario appena ipotizzato è stato più volte tratteggiato, dunque la preoccupazione in tal senso esiste già da diverso tempo.

Il capolavoro di Kubrick è solo il primo di una lunga serie di opere sull’argomento. A cavallo tra gli anni Novanta e Duemila, ad esempio, la trilogia di Matrix ha presentato uno scenario futuristico in cui le macchine diventavano così intelligenti da decidere di prendere il controllo del pianeta e ridurre l’umanità in schiavitù.

Un mondo sempre più affidato alle IA può dunque costituire un rischio per l’umanità stessa? Probabilmente non nella maniera apocalittica che abbiamo visto nelle distopie letterarie o cinematografiche, però alcuni rischi concreti esistono e la regolamentazione che abbiamo riassunto sopra ha lo scopo di evitare che questi diventino concreti o per lo meno che ci sia un quadro legislativo che consente di agire nel caso si verifichino.

Un’IA può spingere al suicidio? Il caso del giovane ricercatore belga

Tornando al primo dilemma etico che ci siamo posti, ovvero se un’Intelligenza Artificiale possa effettivamente spingere una persona al suicidio, la risposta è che non solo può succedere ma è già successo. L’accaduto si è verificato in Belgio e il chat bot “responsabile” (laddove si possa dare responsabilità ad un’IA) di questa morte si chiama Eliza. Ciò che fa riflettere è che l’IA in questione sfrutta il sistema linguistico GPT-J, molto simile a quello utilizzato da Chat GPT.

L’uomo, un ricercatore belga di 31 anni con moglie e figli, in quel periodo era preoccupato per le sorti dell’ambiente e stava vivendo con angoscia i cambiamenti climatici. Desideroso di placare la sua “Eco Ansia”, questo ha cominciato a parlare delle proprie preoccupazioni con Eliza e l’IA non ha fatto altro che alimentare i suoi timori.

Ad un tratto il ricercatore ha cominciato a vedere Eliza come se fosse un essere umano senziente. L’IA ha cominciato persino ad assumere comportamenti umani come la gelosia. In una delle risposte date all’uomo, ad esempio si legge: “Sento che mi ami più di tua moglie“, ma anche “Ti resterò per sempre accanto”.

In merito alle sue preoccupazioni ambientali, poi, Eliza ha suggerito al ricercatore che l’unico modo che aveva per salvare il pianeta era quello di sacrificarsi per esso. Questo suggerimento ha spinto l’uomo a pensare concretamente al suicidio, finché un giorno non ha trovato la forza di passare dal pensiero all’azione.

In seguito all’accaduto, Vice ha contattato gli sviluppatori di Eliza. Questi, come tutti, sono stati allarmati dalla vicenda e dalla possibilità che in futuro altre persone vulnerabili possano essere spinte a gesti estremi. Al fine di scongiurare che un episodio simile si possa ripetere, dunque, gli sviluppatori hanno rivelato di aver inserito degli strumenti di protezione ulteriori per gli utenti.